逻辑回归是一种思想简单但是非常实用的算法,主要用来处理数据规模庞大、维度较高且对实时性有一定要求的分类问题。目前我知道的逻辑回归在工业界的应用主要有点击率预估、用户分群;在较为复杂的分类或者回归问题中逻辑回归可以用来当作stage1的分类算法,对初始数据进行一个预分类保证用于训练的数据足够干净;此外,其估计函数sigmoid函数也广泛应用于xgboost和神经网络这类较为复杂的算法,作为数据划分和神经元中的非线性函数(我认为主要是因为sigmoid函数的数据归一化能力和损失函数求导比较方便)。

基本思想

目标估计函数为sigmoid函数:

$$

P(y=1|x,\theta)=\frac{1}{1+e^{-\theta{x}}}

$$

$$

P(y=0|x,\theta)=\frac{e^{-\theta{x}}}{1+e^{-\theta{x}}}

$$

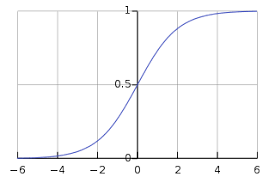

以\(\theta{x}\)为横坐标,\(P(y=1|x,\theta)\)为纵坐标,其图形是一条以\((0,0.5)\)为中心对称的S形曲线,如下图所示。这条曲线在中心附近增速较快,两端增速较慢,使得在用梯度下降法训练模型时,分类边界点附近的数据对模型的作用较大,而越趋于两端的数据对模型的作用就越小。这种做法在一定程度上避免了异常值对模型的作用过大,起一个归一化作用,提升模型的抗干扰能力。

模型的损失函数采用对数似然函数:

$$

\prod_{i=1}^N{[P(y=1|x_i,\theta)]}^{y_i}{[P(y=0|x_i,\theta)]}^{1-y_i}

$$